Premessa

Nel riordinare il materiale di MokaByte, in vista del futuro restyling del sito, ci stiamo soffermando, qua e là, in diversi articoli di molti anni fa. Alcuni presentano idee e visioni che, per quanto importanti al tempo, oramai ci appaiono obsolete e superate. Altri facevano ipotesi, ad esempio su prodotti e tecnologie, che poi non si sono sviluppate come in molti pensavano. Ma ce ne sono alcuni che, a distanza di tanti anni, ci avevano visto giusto.

In tal senso, riproponiamo questo articolo di dieci anni abbondanti fa, in cui, accanto anche a considerazioni che vanno contestualizzate con il panorama ideale e tecnologico del 2010, ce ne sono alcune che preconizzano quanto poi davvero è successo in questo decennio in cui i social media sono divenuti imperanti, anche con i risvolti legati alla verifica dell’attendibilità delle notizie e all’influenza sulle masse di utenti, consumatori ed elettori. Per onestà intellettuale, non abbiamo ritoccato il testo, lasciando quindi anche quelle frasi che, con il senno di poi, potevano essere modificate o migliorate. Ma lo spirito e il senso dell’articolo ci paiono ancora validi. [n.d.aa.]

Aprile 2010

Per molti entusiastici pionieri della cultura digitale, Internet e il Web rappresentano un po‘ l‘avvento di un mondo nuovo, potenzialmente portatore di enormi benefici nei confronti degli utenti. Per alcuni critici, il Web 2.0 rappresenta, testualmente, una rivoluzione che sta uccidendo la nostra cultura e distruggendo la nostra economia. Ma quanto “pesa” il Web 2.0 nella vita dei suoi utenti? Che impatto può avere in termini culturali ed economici sulla nostra società? È possibile valutare concretamente il rientro di operazioni “economiche” condotte usando i social media? Ci sono buone ragioni per cui un‘azienda dovrebbe impegnarsi seriamente a conoscere e usare queste nuove tecnologie? E come si può misurare il ROI di tali campagne?

Introduzione

Nella prima parte di questa serie spiegavamo come ci interessasse riflettere e porre l’attenzione dei nostri lettori sull’attuale panorama IT in senso lato, non tanto in termini di tecnologie, framework e piattaforme, quanto più da un punto di vista degli aspetti “sociali” e “comportamentali”. Ci interessava riflettere, pur con tutti i limiti che riconosciamo alla nostra trattazione, sui modelli di business e sulle infrastrutture tecnologiche che oggi diamo per scontati, ma di cui spesso vediamo parzialmente soltanto alcune delle molteplici sfaccettature.

Avevamo specificato che il taglio degli articoli avrebbe proposto anche esempi reali e soluzioni possibili, dal momento che l’impronta delle nostre considerazioni è legata a doppio filo all’esperienza maturata in realtà aziendali, progetti di sviluppo, attività di consulenza e di formazione. Ci interessa, e lo ribadiamo, un approccio relativamente pragmatico che però non deve prescindere dagli studi e dai dibattiti che affrontano con competenza questi temi, sollevando problemi, valutando le prospettive, ipotizzando tendenze ed evoluzioni.

Internet non è il paradiso

I personal computer prima e la loro successiva interconnessione nella “rete delle reti” hanno rappresentato delle tecnologie “abilitanti”, che hanno permesso in molti casi la realizzazione di potenzialità (personali, sociali, imprenditoriali) che mai si sarebbero trasformate in positivi casi di successo senza tali tecnologie. Guardare al mondo digitale senza riconoscere tali benefici estesi significa essere miopi o in cattiva fede. Ma è ingenuo anche un atteggiamento di cieca fiducia nelle “sorti progressive del web”, quasi che inevitabilmente i futuri sviluppi della rete e i suoi riflessi sulla società e sull’economia debbano essere necessariamente soltanto positivi.

In tal senso, sebbene nel panorama italiano non abbia avuto molto spazio, ha suscitato grande dibattito in particolare negli Stati Uniti un libro del 2007, intitolato “The cult of the amateur” , ripubblicato l’anno dopo con l’aggiunta di alcune parti [1]. L’autore di questo libro, il britannico Andrew Keen, è stato estremamente attivo nel periodo della new economy: le sue critiche feroci alle attuali tendenze del Web sono state accolte con grande e malcelato disappunto dai protagonisti del Web 2.0 forse proprio perche’ provenienti da un esponente interno a quel mondo, che vive negli USA e ha operato per anni in diverse società della Silicon Valley.

In pratica, partendo dalle sue esperienze dirette, dalle considerazioni di altri autori [2] e da una serie di dati opportunamente raccolti, l’autore critica non tanto le tecnologie e le piattaforme alla base del Web 2.0 (network sociali, interfacce “ricche”, rapidità e ubiquità della connessione) ma ciò che con questa infrastruttura si fa: User Generated Content (UGC) ossia il “contenuto generato dagli utenti” e la pratica della “disintermediazione” che, se da un lato sembra democratizzare lo strumento, dall’altro finisce per porre sullo stesso piano tutte le informazioni, senza filtro e senza, diciamo così, un controllo di qualità. Prende piede quello che Andrew Keen considera appunto “il culto del dilettante nobile” (il titolo della traduzione italiana del suo libro è appunto “Dilettanti.com”), che può mettere in crisi secoli e secoli di conquiste culturali.

Attraverso argomentazioni supportate da dati, Keen prende di mira alcuni fenomeni importanti nel mondo IT del primo decennio degli anni Duemila, criticando aspramente:

- il giornalismo partecipativo;

- la presunta “saggezza delle masse” che sarebbe in grado di discernere il vero dal falso;

- le truffe e gli episodi “estremi” che avvengono tramite la rete (dall’adescamento ai fini di crimini sessuali, al bullismo perpetrato in vista della pubblicazione di un video su YouTube, ai furti di identità…);

- il pericolo di un controllo sociale sugli utenti, alla Big Brother, perpetrato dai grandi gruppi informatici detentori di dati e informazioni derivanti dagli scambi e dalle ricerche compiute online (Google per primo);

- la poca autorevolezza di strumenti culturali come Wikipedia (cui, al di là dei veri e propri errori in certe voci, viene più che altro imputato che il suo sapere condiviso è in definitiva un sapere “medio”, che accontenta tutti, dovendo mediare tra le riscritture di centinaia di autori, senza vere punte di eccellenza e senza autorevolezza);

- la pratica del “copia-incolla” e del “remix” per cui gran parte del tanto osannato contenuto generato dagli utenti (UGC) è spesso tutt’altro che originale ed è frutto di un superficiale processo di riassemblamento di elementi preesistenti, con un generale scadimento della qualità dei contenuti culturali e artistici (fatte salve alcune eccezioni).

Vengono inoltre raccontati alcuni episodi concernenti il fallimento o il ridimensionamento di imprese e professioni legati all’industria culturale, dovuti a fenomeni quali il file-sharing selvaggio e il conseguente generale appiattimento del gusto dovuto al fatto che coloro che dovrebbero investire in arte e cultura non lo fanno più come un tempo, visto che viene a mancare il rientro degli investimenti. Nel dettagliato racconto del progressivo declino dell’industria musicale, cui l’autore dedica ben due capitoli, pesa sicuramente l’esperienza di Keen, che è stato tra i pionieri della distribuzione legale della musica su Internet, già nella seconda metà degli anni Novanta.

Come detto, a differenza che negli Stati Uniti, da noi il libro ha suscitato un interesse piuttosto marginale, forse anche perche’ gli attacchi diretti a personaggi come Tim O’Reilly, o ai direttori e caporedattori di Wired USA sono troppo “localizzati”, per usare un termine informatico, e abbastanza lontani dalla nostra realtà nazionale… E forse va detto che se certe idee dissacranti di questo libro (ma anche di molti altri autori critici che nel mondo IT e Web si muovono da sempre) sono interessanti e solide, è anche vero che in certi casi sembrano prevalere il gusto per l’invettiva o la propensione alla letteratura distopica che tanto è importante nel mondo anglosassone, ossia quel genere che descrive le “anti-utopie”, rappresentando una società fittizia, indesiderabile sotto tutti i punti di vista, nella quale le tendenze sociali sono portate ad estremi apocalittici: si pensi, su ben altri livelli e con ben altro valore culturale, anche solo alle opere di George Orwell, con il suo “1984” in testa, o al timore fondato che la tecnologia serva al controllo politico e sociale, più che alla liberazione delle masse.

Va però notato che, in definitiva, molte delle critiche del libro sono rivolte più alla qualità bassa dei contenuti che il Web 2.0 tende a veicolare in accordo ai concetti di UGC e disintermediazione che non alle tecnologie che ne sono alla base. E va detto anche che, se è assolutamente legittimo dissentire dalle visioni ottimistiche di O’Reilly Media o della rivista Wired, basate sulla fiducia nell’inarrestabile progresso digitale, sul miglioramento della conoscenza derivante dal semplice “essere in rete”, su un modello socio-culturale globalizzato livellato verso l’alto, si dovrebbe anche riconoscere che, per esempio, il contenuto delle pubblicazioni della casa di Sebastopol è affidato a esperti di alto livello (spesso gli autori dei libri su certe tecnologie sono gli “inventori” stessi di tali tecnologie e non dei “nobili dilettanti”) e che per quanto visionarie e geek possano apparire le proposte di Wired, questa rivista continua a rappresentare comunque un interessante punto di riferimento per la riflessione su storie, idee e persone che hanno influenza sul mondo tecnologico e sul rapporto tra tecnologia, economia e società.

In pratica, quindi, ci pare più sensato l’atteggiamento equilibrato per cui Internet non è il paradiso, ma neanche l’inferno, a patto che si usi nel modo più consapevole possibile.

Time to market e qualità

Pur senza accettare le prospettive fortemente pessimistiche di Keen e dei suoi seguaci, è però indubbio che ci sono dei limiti con cui ci dobbiamo confrontare. Senza andare ad approfondire la classica frase che i non addetti ai lavori tendono a ripetere, per esempio, al giovane progettista web (“In fondo che ci vuole a fare un sito tipo Facebook? Ci pensa il computer no?”), il problema della contrazione dei tempi e del conseguente abbassamento della qualità del prodotto finale è presente a tutti coloro che, ai diversi livelli e con diverse mansioni, si siano confrontati con attività di progettazione e sviluppo di una qualche complessità. Ed è qui che alcuni dei potenziali problemi legati al Web 2.0 devono essere ben presenti a chi, per esempio, lavori a qualsiasi progetto in cui comunicazione, interazione con gli utenti, contenuti “liberi” ricoprano un ruolo importante.

Il rapporto tra qualità di ciò che produco (una piattaforma di e-commerce, il sistema gestionale di una banca, un sito con tecnologie RIA) e il cosiddetto time to market ha dei valori non contraibili [3]. La classica obiezione che si porta in tale situazione è che la realizzazione di una attività non è legata solo al concetto di ore-uomo, ma anche a variabili molto più complesse, alcune delle quali hanno i loro tempi che non possono essere ridotti: molto ipoteticamente, se ho 600 mattoni da spostare e occorre 1 secondo per spostare ogni mattone, a un lavoratore occorreranno circa 600 secondi (10 minuti) per spostare tutti i mattoni. Se affianco al primo lavoratore un secondo operaio che fa le stesse cose, il lavoro verrà concluso in 5 minuti. Ciò non vale però per altri tipi di “attività”: se a una donna incinta affianco un’altra donna, non è che il bambino nascerà in quattro mesi e mezzo… Ci sono tempi, non solo biologici, ma anche culturali, che non possono essere contratti, almeno non al livello in cui certa cultura digitale farebbe ipotizzare. Questo è chiaro a chi le cose le deve produrre (sviluppatori, architetti, autori dei contenuti, project manager “illuminati”) ma meno assodato magari per il committente che paga ma non è addentro a certe dinamiche.

Qui, veramente, alcuni concetti “sociali” del Web 2.0 possono risultare ingannevoli: nel momento in cui mi rendo conto che, per esempio, una campagna di marketing sul mio prodotto mi costa troppo, mi richiede troppo tempo, rischia di apparire comunque vecchia e non al passo con le nuovissime tendenze… perche’ non buttarsi sui social media, delegando agli utenti la creazione dei contenuti e la “conversazione” riguardo alla mia marca? Se ai più tradizionalisti questa scelta sembra azzardata, è quel che Skittles, la marca di caramelline colorate, ha fatto nel 2009, salvo poi pentirsi amaramente della degenerazione che tale scelta aveva subito: sul loro sito ufficiale trasformato per l’occasione in una sorta di mirror dei post sui social media più importanti, ben presto si era passati da commenti inerenti il prodotto a post privi di relazione con la marca, spesso a sfondo offensivo se non osceno, senza più rapporto con il contesto [4]. Inutile dire che l’esperimento è stato chiuso in tempi brevi e che si è provveduto con accuratezza a far sparire le tracce del misfatto anche dai motori di ricerca che permettono di vedere lo stato di un sito in una sua forma precedente… Per non parlare dell’Employee Branding [5]: in teoria la migliore forma di pubblicità per qualsiasi impresa, in pratica funziona solo nelle aziende “modello” che, ahinoi, sono pochissime rispetto al totale.

Per quanto il Web 2.0 metta a disposizione un’infrastruttura potente e un’enorme massa di utenti tra loro interconessi, resta il fatto che progetti complessi (di sviluppo software, di gestione e archiviazione dei dati, di web marketing etc.) continuano a richiedere il loro investimento di tempo e denaro. Che certo non sarà enorme quanto quelli di un tempo, ma non può essere contratto eccessivamente…

Quindi il Web 2.0 è da rigettare? A parte che sarebbe “tecnicamente” impossibile, non lo pensiamo affatto. Abbiamo voluto mettere in luce tanti aspetti negativi del Web 2.0, proprio per poterlo usare in maniera consapevole e fruttuosa. Nell’ottica giusta e con le adeguate conoscenze, i social media, per esempio, possono essere un ottimo veicolo per diffondere idee e contenuti di qualità, nonche’ per fare campagne di comunicazione di valore. E inoltre, tutto questo può essere “misurato” (le virgolette sono d’obbligo): vedremo come nei prossimi paragrafi.

Utenti e tecnologie: pionieri e massa critica

Prima di addentrarci nella tematica delle “metriche” per misurare l’impatto del web, spendiamo ancora due parole riguardo a concetti tanto noti quanto sottovalutati: ciclo di adozione di una tecnologia, massa critica, specificità locali/nazionali/culturali.

Il ciclo di adozione

Il primo aspetto da tenere in considerazione è che la deleteria prospettiva del “tutto e subito” cui spesso si deve sottostare, fa perdere di vista uno sguardo d’insieme a lungo termine su strumenti e tecnologie: a fronte degli utenti più rigidi che mal digeriscono per principio le innovazioni e adottano certe tecnologie solo in una fase ormai tarda del loro sviluppo, è sempre esistita una minoranza di pionieri, di “early adopters” che, per le più svariate ragioni (necessità professionali, interesse personale, inveterata propensione geek…), vedono nel nuovo una occasione di sperimentazione da non farsi scappare.

Nel valutare le tecnologie quindi, occorre capire fin dal principio da quale punto di vista decidiamo di farlo: se ci interessa il ruolo di pionieri (e può avere un senso) o se ci interessano i benefici derivanti da una tecnologia ormai affermata e “matura” (anche se ormai considerata vecchia dagli “early adopters”).

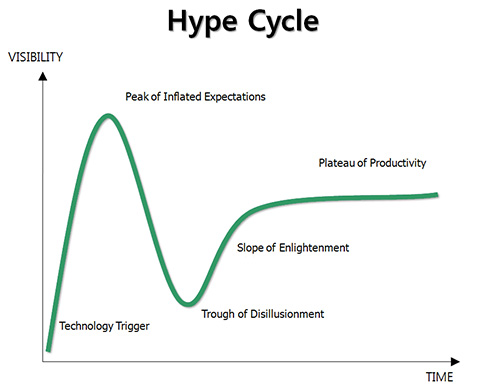

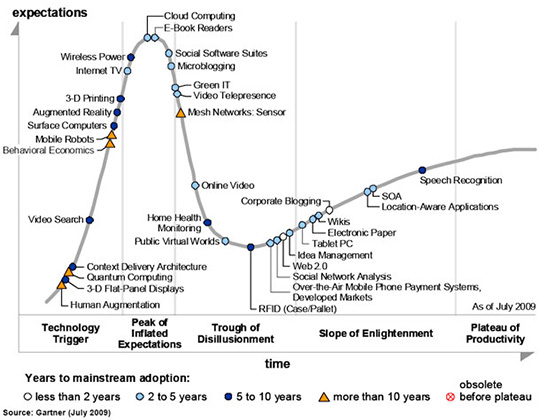

La società Gartner ha messo a punto un modello di analisi delle innovazioni che ha definito “ciclo di hype” [6] e che tende a descrivere quel che generalmente avviene a una tecnologia nuova: da una fase di notevoli aspettative, spesso esagerate dai media, si passa a una fase di disillusione, che può poi evolversi in una più o meno ampia adozione matura della tecnologia stessa.

Massa critica

Accanto a questo andamento che tutti possono riscontrare pensando ad alcuni “fenomeni” degli ultimi dieci/quindici anni, c’è un ulteriore aspetto da prendere in considerazione ed è quello del numero effettivo di utenti. Prendiamo due fenomeni “sociali” che si sono contesi in periodi successivi l’attenzione dei media tradizionali (che spesso faticano a comprenderli e a spiegarli…): Second Life e Facebook. Al di là delle notevoli differenze di interfaccia e di modalità d’uso (non tanto di “tempo necessario a usarli” visto che ci sono utenti dell’una e dell’altra piattaforma disposti a trascorrere ore nell’abbellire il loro avatar o nel creare album fotografici, gruppi, pagine e quant’altro da condividere con gli amici), entrambi questi strumenti sociali hanno dominato le pagine di giornali e gli schermi della TV per tutto il periodo di “picco delle aspettative”. Ma c’è una differenza sostanziale: a fronte del pur notevole milione e mezzo di utenti attivi su Second Life, piattaforma già giunta ben oltre l’iniziale picco di aspettative gonfiate e considerata tra quei “mondi virtuali” attualmente posti nella fase discendente del “passaggio alla disillusione”, un social network come Facebook vanta 400 milioni di utenti attivi che, anche se non si collegano tutti i giorni [7] rappresentano comunque una incontestabile massa critica, in cui individuare con successo un potenziale gruppo bersaglio per una data campagna di comunicazione (pubblicitaria, educativa, culturale, politica, etc.). E non va dimenticato che proprio grazie a strumenti del genere, si sono avvicinate al mondo digitale persone che fino ad allora ne erano rimaste abbastanza ai margini (controllate tra i vostri contatti di Facebook, prima di dire che non è vero…). Insomma… il numero non è tutto, ma non bisogna mai dimenticare un concetto importante come quello di massa critica.

Specificità locali/nazionali

Perche’ certi social media abbiano avuto maggiore successo di altri è fatto complesso e spiegabile solo con una trattazione che esula dai confini di questo articolo. Di certo vale, come per tutto, il concetto di “motivazione”: l’utente affronta un determinato nuovo paradigma e vi rimane fedele se la motivazione che lo spinge a usarlo resta sufficientemente elevata nel lungo periodo. E “sufficientemente elevata” non significa affatto “altissima”, ma semplicemente “tale da giustificare lo sforzo necessario a usare quello strumento”. In pratica, è il vecchio detto del gioco che vale la candela. Ma questa considerazione ci porta a un’ultima riflessione: l’Italia è il 6o paese per numero assoluto di iscritti a Facebook (dopo USA, UK, Canada, Turchia e Francia, quindi paragonando la nostra nazione anche a Paesi con un numero di abitanti maggiore) e la pagina di login di Facebook è la 2a più visitata ogni giorno in Italia (dopo Google) [8]: in questo exploit che ci pone ben più avanti di nazioni europee grandi e propulsive come la Germania o di nazioni con una vivace industria high tech come la Finlandia, pensate che proprio non contino la tradizionale, italianissima propensione alla conversazione e al contatto, nonche’ la struttura più familistica e amicale, rispetto a quelle del nord Europa, tipica della nostra società?

Seppure in un mondo globalizzato, e con un mezzo senza frontiere come Internet, per proporre una qualsiasi strategia, occorre sempre considerare le specifiche caratteristiche locali dei vari ambiti geografici e culturali senza limitarsi a copiare pedissequamente strategie e stilemi tipicamente statunitensi.

Misurare l’impatto

Giungiamo infine a una proposta, certamente opinabile e con i suoi limiti, di valutazione dell’impatto “economico” dei social media. Abbiamo presentato senza remore una serie di critiche al mondo Web 2.0. Abbiamo mostrato alcuni modelli interpretativi del fenomeno. Abbiamo messo in guardia da facili semplificazioni, prendendo in considerazione anche certe specificità “territoriali”. A questo punto intendiamo presentare alcune possibilità di “misurazione” di quello che in effetti il web può “fruttare”.

Diciamo per completezza anche che i più accorti esperti di marketing tendono oggi a rigettare certe semplificazioni “meccanicistiche”. Giampaolo Fabris, uno dei sociologi italiani più importanti, pioniere degli studi demoscopici negli anni Sessanta e Settanta e inventore del termine “societing” da contrapporre a quello più limitato di “marketing”, spiega nel suo recente saggio “La società post-crescita” [9] come certi strumenti di misura (ad esempio, il PIL per l’economia degli Stati) o certe impostazioni standardizzate nel marketing (“pattern” per il successo delle imprese e dei prodotti), o nelle analisi economiche, pur se adottate con successo nello scorso secolo, tendano oggi a mostrare tutti i loro limiti, in un quadro economico e culturale ormai irrimediabilmente mutato. Molto interessante, però, è come in questo saggio si notino tutte le potenzialità del web e dei suoi utenti, intesi anche come consumatori più o meno consapevoli, ai fini del successo o dell’insuccesso di determinati prodotti, dell’affermazione o del cambiamento di determinati stili di vita. Una prospettiva autorevole che, pur senza esaltare ingenuamente il mito del web salvifico e quasi avulso dal resto della realtà che anima troppi utopisti sostenitori di tale visione, si contrappone nettamente alle previsioni più negative dei disillusi alla Andrew Keen.

Analisi dei siti web

Partiamo da un set di analisi di tipo “tradizionale” che, seppur conosciute e impiegate da tempo, risultano comunque molto importanti per misurare il valore e l’impatto di determinate azioni sul web. Ci riferiamo alle varie tecniche di “web analytics” che tutti i nostri lettori conoscono, basate per esempio sull’analisi dei log dei server web (con appositi software) o su meccanismi presenti nelle pagine che consentissero il conteggio degli accessi in tempo reale: tutti ricorderanno le pagine con il “contatore”, un primordiale sistema di metriche web, che ha perso di significato con il diffondersi degli spider automatizzati e di tecnologie quali AJAX che non ricaricano la pagina completa, senza pensare inoltre al peso dei dati salvati nella cache dei browser. È chiaro che, al di là del conto pagine, per quanto riguarda i log dei server web, si tratta di analisi che possono essere fatte solo “dall’interno”, ossia avendo accesso ai file che registrano gli accessi a un sito. Nate fin dalla metà degli anni Novanta, queste misurazioni hanno dato vita, per esempio, a termini come “page view” o “accesso unico”. In pratica, questi tipi di analisi ci dicono quando, da dove e per quanto tempo un determinato utente ha avuto accesso a una pagina di un sito.

E nonostante esistano oggi delle tecnologie promettenti ed estremamente più raffinate, di cui parleremo subito dopo, questo tipo di analisi continua a mantenere un grande significato, tanto da essersi sviluppate nelle analisi dei click, le quali consentono di capire esattamente cosa fanno gli utenti una volta arrivati su una pagina (quali link cliccano, dopo quanto abbandonano la pagina, da quali parti della pagina sono maggiormente attratti, quanto risultano efficaci i link sponsorizzati e così via). Ci danno, insomma, delle indicazioni sul modo di operare da parte degli utenti, valutando quello che l’utente fa effettivamente tra le possibilità che gli vengono proposte.

A fronte di questo approccio “interno”, ciò che si sta diffondendo è il tentativo di condurre analisi “dall’esterno” con strumenti di indagine del web per misurare il sentiment della blogosfera su quanto detto riguardo a una marca, o a una campagna, o a un sito o su un dato tema in generale.

Analisi dei network sociali

Il social web ha introdotto un nuovo modo di gestire la comunicazione fra persone: e questo vale per le relazioni interpersonali più ristrette, per le dinamiche di scambio all’interno di grandi gruppi (forum, portali sociali etc.), e anche per le relazioni commerciali che si instaurano fra i clienti e le aziende. Va oltretutto sottolineato come in questo mondo (chiamiamolo Web 2.0, o blogosfera, o social web o come vogliamo) ognuno di noi si muove interpretando molteplici ruoli in funzione del contesto e delle operazioni che svolgiamo (il responsabile di una azienda che ne gestisce la presenza su un social media magari ha una presenza diversa e personale sullo stesso o su un altro network sociale).

Nello scrivere questo articolo il ruolo degli autori è di un certo tipo, più “tradizionale” (anche perche’ per esempio Giovanni scrive su MokaByte da più di 10 anni); ma nel momento in cui si passa, per esempio a Facebook, si assume un ruolo completamente differente, perdendosi nel mare degli utenti che scrivono impressioni, postano commenti, condividono fotografie. E se nel caso degli articoli su MokaByte si cerca di fornire informazioni basate su studi ed esperienze professionali, quando poi gli autori si mettono alla ricerca di informazioni legate a un particolare settore di cui non sanno molto, allora si affida a quello che altri più autorevoli ed esperti in quel settore hanno scritto da altre parti (di fatto rovesciando il ruolo che si instaura con chi sta leggendo questo articolo).

La rete quindi è popolata da utenti che hanno pesi e spostano opinioni in modo differente in funzione di quello che dicono o fanno e soprattutto dipendentemente da dove lo fanno. Questa considerazione che potrebbe apparire ovvia, in realtà è molto meno banale di quanto si potrebbe immaginare, tanto che inizia a essere oggetto di indagine e approfondimento da parte non solo di studiosi accademici ma anche di esperti aziendali di comunicazione e di chi vede nel social web un nuovo interessantissimo strumento per fare marketing (quindi in definitiva per promuovere un concetto, un servizio, un prodotto). Anche se la terminologia fa sorridere dalle nostre parti, negli USA, dove questo settore di indagine è molto più sviluppato, almeno da un punto di vista di volume, che da noi si parla con la massima serietà di profili professionali come il “brand embassador” (ambasciatore della marca) o “brand evangelist” (predicatore della marca), leader di pensiero, power account etc. e contemporaneamente si vede lo studio dei comportamenti degli utenti della rete come una importante opportunità più che una minaccia.

È importante non sottovalutare il fenomeno se è vero che ci sono aziende che hanno investito fortemente in questo mercato tanto che offrono non solo suggerimenti per migliorare le tecniche di comunicazione (formazione nel settore della comunicazione nei social media), ma propongono l’utilizzo di veri o propri strumenti di indagine statistica e numerica per poter dedurre quale è il reale effetto della veicolazione di un determinato messaggio in rete.

Cambiamento di prospettiva

Come si è avuto modo di dire poco sopra, il web ha di fatto cambiato il modo di intendere il rapporto fra chi parla e chi ascolta. La prima grossa differenza rispetto al passato consiste nel fatto che la comunicazione non è più monodirezionale (dal produttore del messaggio, attraverso il mezzo, all’ascoltatore): chiunque può esprimere un parere su questo o quel messaggio sia in modo generico sulle varie piattaforme di blog, forum, social network di vario tipo sia direttamente postato sul sito di chi ha fatto o detto qualcosa. Nel libro “Il marketing nel social web” [10] sono riportati numerosi esempi di aziende che si sono scontrate con questo nuovo fenomeno sociale. Dalla fase iniziale in cui il mondo sociale veniva visto come una minaccia (perdere reputazione nell’era del web è una cosa molto facile) siamo passati a esempi di comportamenti più o meno virtuosi, basati sul fatto che oggi non è più possibile considerare il cliente come un fruitore passivo e arrendevole di ogni tipo di messaggio.

Come già detto [9], il parere del consumatore non può più essere ignorato e la massa della popolazione della blogosfera ha un peso che può in parte influenzare equilibri di mercato. “Il marketing nel social web” riporta chiaramente come vincenti quelle aziende che hanno saputo instaurare per prime un rapporto trasparente senza cercare di nascondere gli errori ma anzi condividendo limiti e cercando suggerimenti e idee presso i clienti nel cercare di superare le difficoltà.

Il web collaborativo, quindi, da minaccia è diventato una risorsa di grandissimo valore. Riuscire a capire cosa dice l’utente finale è la vera sfida attuale e può regalare posizioni di vantaggio nei confronti della concorrenza. Del resto, l’idea che “i mercati sono conversazioni”, era presente già nel celebre Cluetrain Mainfesto [11], che più di dieci anni fa conteneva lo slogan “partecipazione è marketing”: tutti possono e devono assumere un ruolo attivo nelle comunicazioni; le aziende parlano fra loro e con i loro clienti abituali e potenziali, e i social media offrono la parola ai consumatori.

Ma cosa deve fare il produttore di un messaggio (non limitiamo l’attenzione alla sola azienda che produce beni, poiche’ sarebbe un approccio troppo ristretto) per capire come viene recepito dalla comunità? Quali sono gli strumenti a disposizione per misurare il ROI (Return On Investment o indice di redditività del capitale investito) in ambito social web? In sintesi, in cosa si distingue il social media marketing?

Le varie fonti identificano due approcci al processo di indagine del mondo del social web: la prima, più tradizionale, ha come obiettivo conoscere nel minimo dettaglio il proprio destinatario, cercando di capire cosa venga detto nelle relative community di utenti e proponendosi di entrare in tali comunità non come intruso ma come uno dei tanti utenti attivi, non per vendere e pilotare le scelte ma per dare consigli neutrali e il più possibile disinteressati.

In questo senso è importante conoscere le comunità giuste e conoscere il comportamento degli utenti della comunità nel suo complesso (come se fosse un superorganismo): capire quali sono gli interessi generali o specifici sul prodotto/messaggio/concetto che si intende promuovere, cercare di identificare peculiarità comportamentali dei membri. Ad esempio, c’è una stagionalità nella partecipazione? In un forum di allevatori/agricoltori mi posso aspettare che nei momenti di massimo impegno siano meno presenti in rete perche’ impegnati sul campo, così come posso capire che gli appassionati di motociclismo in inverno avranno meno contenuti da postare e forse saranno meno interessati a rinnovare la loro attrezzatura.

A volte essere trasparenti e sinceri può essere il modo migliore per ottenere la fiducia della comunità: se sono un produttore di scarpe da trekking posso entrare a far parte della comunità di appassionati presentandomi chiaramente con il nome del mio brand (nome azienda o di un mio prodotto specifico), senza nascondere che in qualità di azienda sono interessato a vendere il più possibile, ma magari offrendo gratuitamente alla comunità il parere equilibrato dei miei tecnici migliori, pubblicando risultati di ricerche condotte e non avendo paura di dire cose che sulle prime vorrei dire soltanto a chi compra i miei prodotti. Questo atteggiamento (che per esempio in MokaByte abbiamo da sempre adottato, anche in periodi pre-social media marketing) alla fine è pagante.

Il secondo modo con cui il produttore del messaggio può comprendere la reale accettazione della propria campagna di comunicazione è quello di utilizzare strumenti statistici e numerici. A tal proposito va notato come stiano diffondendosi sul mercato delle aziende che svolgono a pagamento delle ricerche inerenti il valore della propria “presenza” sul web, quali Radian6 [12] o Vitrue [13].

Tramite tool simili a motori di ricerca che indicizzano il mondo della blogosfera trovando messaggi e commenti di vario tipo, è infatti possibile sia contare il numero dei commenti (quante volte in rete compare la parola MokaByte a fianco di un post di un programmatore Java che è anche lettore della nostra rivista), ma anche di classificarli in base ai giudizi negativi. L’indagine si può svolgere anche su canali diversi dal web tradizionale (quello basato sul browser), come Twitter [14] o Twittfeel [15]. I risultati riportati dai rispettivi provider di tali servizi propongono una accuratezza dei risultati che si attesta intorno a percentuali dell’80, 85 e perfino 90% (pare grazie all’utilizzo di sistemi di classificazione basata su algoritmi di valutazione intelligente). Non siamo in grado al momento di poter verificare tali affermazioni, ma è comunque significativo constatare il livello di attività che il settore offre.

Indipendentemente dallo strumento adottato, poter misurare il cosiddetto “social sentiment” ha il duplice effetto di poter verificare il ROI di una campagna e di poter decidere come agire per attuare al meglio il cosiddetto controllo della “reputation management” che ha una valenza più ampia rispetto alla ROI. In ambito di reputation management, gli esperti suggeriscono, sia per mezzo della partecipazione diretta nel mondo sociale o tramite strumenti di indagine statistica, di tenere sotto controllo 12 punti:

- il vostro nome

- il nome della vostra azienda

- i nomi dei marchi

- i direttori della azienda

- i rappresentanti dell’azienda presso i media

- gli slogan o messaggi di marketing

- la concorrenza

- il vostro settore

- i vostri punti deboli

- i vostri partner in affari

- i vostri clienti

- la vostra proprietà intellettuale

In conclusione è comunque importante tenere bene a mente che la strada del marketing in ambito social network ha molti aspetti simili a quello tradizionale, non ultimo il fatto che comunque costa denaro e soprattutto richiede tempo: il fatto che sia portato avanti con strumenti di comunicazione veloci non implica che i risultati si possano ottenere in tempi analoghi. È necessaria una presenza costante e continuativa per conquistare la fiducia del cliente e i risultati si ottengono sul lungo periodo. Affidarsi a esperti del settore che svolgano compiutamente il compito di manager del canale sociale, sia come interni che come consulenti esterni, è sicuramente una buona idea perche’ nel primo caso permette di dedicare il tempo appropriato a tale delicata mansione (non è una cosa che può essere fatta nei ritagli di tempo libero di altri compiti), nel secondo scarica il team interno di un compito gravoso, che richiede competenza ed esperienza.

Conclusioni

Siamo partiti dalla analisi di alcuni aspetti “negativi” legati al Web 2.0: i limiti insiti in un tale modello vengono troppo spesso ignorati, specie da chi opera proprio nel mondo delle tecnologie di programmazione e di sviluppo. Ma, senza cedere alle visioni catastrofiche, la consapevolezza dei problemi generali deve anzi servire per approfondire modelli di funzionamento e potenzialità del mondo digitale.

Abbiamo pertanto presentato alcuni aspetti particolari da tenere presenti nell’adozione e nella gestione di tecnologie web “sociali”, non ultime le specificità culturali e geografiche, in molti casi dimenticate in un modello a “trazione” nordamericana.

Siamo infene arrivati alla presentazione di alcune tematiche relative alla misurazione dell’impatto delle azioni che si compiono nei web sociali, anche in termini di marketing e di presenza valide per la promozione di prodotti, campagne, concetti: se non a una vera e propria misurazione diretta del ROI (cui si sta comunque arrivando) è possibile per ora giungere alla valutazione attendibile del “social sentiment”.

Proseguiremo nei prossimi numeri le nostre riflessioni sui diversi aspetti del web sociale. [n.d.aa.: ovviamente si riferisce agli articoli di questa serie del 2010]

A MokaByte mi occupo dei processi legati alla gestione degli autori e della redazione degli articoli. Collateralmente, svolgo attività di consulenza e formazione nell‘ambito dell‘editoria "tradizionale" e digitale, della scrittura professionale e della comunicazione sulle diverse piattaforme.

Giovanni Puliti ha lavorato per oltre 20 anni come consulente nel settore dell’IT e attualmente svolge la professione di Agile Coach. Nel 1996, insieme ad altri collaboratori, crea MokaByte, la prima rivista italiana web dedicata a Java. Autore di numerosi articoli pubblicate sia su MokaByte.it che su riviste del settore, ha partecipato a diversi progetti editoriali e prende parte regolarmente a conference in qualità di speaker. Dopo aver a lungo lavorato all’interno di progetti di web enterprise, come esperto di tecnologie e architetture, è passato a erogare consulenze in ambito di project management. Da diversi anni ha abbracciato le metodologie agili offrendo ad aziende e organizzazioni il suo supporto sia come coach agile che come business coach. È cofondatore di AgileReloaded, l’azienda italiana per il coaching agile.